Regresión

El término regresión fue introducido por Francis Galton en su libro Natural inheritance (1889) y fue confirmada por su amigo Karl Pearson. Su trabajo se centró en la descripción de los rasgos físicos de los descendientes (variable A) a partir de los de sus padres (variable B). Estudiando la altura de padres e hijos a partir de más de mil registros de grupos familiares, se llegó a la conclusión de que los padres muy altos tenían una tendencia a tener hijos que heredaban parte de esta altura, pero que revelaban también una tendencia a

regresar a la media. Galton generalizó esta tendencia bajo la "ley de la regresión universal": «Cada peculiaridad en un hombre es compartida por sus descendientes, pero en media, en un grado menor.»

Las técnicas de regresión permiten hacer predicciones sobre los valores de cierta variable

Y (dependiente), a partir de los de otra

X (independiente), entre las que intuimos que existe una relación.

Tipos de regresión:

Regresión lineal

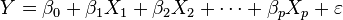

En estadística la regresión lineal o ajuste lineal es un método matemático que modeliza la relación entre una variable dependiente Y, las variables independientes Xi y un término aleatorio ε. Este modelo puede ser expresado como:

donde β0 es la intersección o término "constante", las  son los parámetros respectivos a cada variable independiente, y p es el número de parámetros independientes a tener en cuenta en la regresión.

son los parámetros respectivos a cada variable independiente, y p es el número de parámetros independientes a tener en cuenta en la regresión.

Dadas dos variables (Y: variable dependiente; X: independiente) se trata de encontrar una función simple (lineal) de X que nos permita aproximar Y mediante: Ŷ = a + bX

- a (ordenada en el origen, constante)

- b (pendiente de la recta)

- A la cantidad e=Y-Ŷ se le denomina residuo o error residual.

Así, en el ejemplo de Pearson: Ŷ = 85 cm + 0,5X

- Donde Ŷ es la altura predicha del hijo y X la altura del padre: En media, el hijo gana 0,5 cm por cada cm del padre.

- Regresión lineal múltiple

Regresión no lineal

En estadística, la regresión no lineal es un problema de inferencia para un modelo tipo:

basado en datos multidimensionales x,y, donde f es alguna función no lineal respecto a algunos parámetros desconocidos θ. Como mínimo, se pretende obtener los valores de los parámetros asociados con la mejor curva de ajuste (habitualmente, con el método de los mínimos cuadrados). Con el fin de determinar si el modelo es adecuado, puede ser necesario utilizar conceptos de inferencia estadística tales como intervalos de confianza para los parámetros así como pruebas de bondad de ajuste.

son los parámetros respectivos a cada variable independiente, y p es el número de parámetros independientes a tener en cuenta en la regresión.

son los parámetros respectivos a cada variable independiente, y p es el número de parámetros independientes a tener en cuenta en la regresión.

No hay comentarios:

Publicar un comentario